Grande nouvelle, avec l’arrivée de l’Internet, la généralisation des écrans couleurs de grande taille, le développement de la puissance de calcul et de stockage compatibles avec l’usage de l’image et du son, nous sommes enfin entrés dans la préhistoire de l’informatique!

La magie de l’écran vert du célèbre Apple II

(Source : Wikipedia.org)

Avant, c’était le néant ou plutôt l’écran noir avec un curseur vert clignotant. Nulle communication n’était possible entre les ordinateurs puisque le réseau des réseaux était un concept de chercheur. La créativité de l’ordinateur se résumait à des calculs et du traitement de texte dans les deux sens du terme. Certains visionnaires (ou plutôt des fous) s’extasiaient sur le réalisme graphique d’un vaisseau spatial constitué de 4 carrés noirs et 5 carrés blancs.

Le mythique Space Invader

(Source : Arcade history)

Puis avec l’apparition de la souris , des interfaces graphiques et d’une interface homme/machine plus proche de la facilité d’utilisation des objets de notre quotidien (livre, télévision, voiture…), l’informatique grand public est née, preuve s’il en était besoin de l’entrée dans une ère nouvelle : le paléolithique de l’informatique.

Certains technologues enthousiastes, qui sont nombreux parmi nos lecteurs, à la lumière de cette introduction pourraient penser qu’il s’agit d’une humeur comique ou d’une boutade ironique sur l’informatique d’aujourd’hui, alors qu’il n’en est rien !

Je suis sérieux et je persiste et signe : le grand marketing vous ment, le grand marketing vous exploite, le grand marketing vous spolie ! Votre iMac rutilant n’est qu’un jouet comparable en efficacité au couteau de rahan !

L’iMac, un jouet ou un ordinateur?

(Source : Wikipedia.org)

Mon micro ordinateur, un jouet ?

Mais soyons réaliste, peut-on aujourd’hui s’émerveiller sur la puissance de nos ordinateurs, sur leur facilité d’utilisation ou sur les possibilités d’utilisation ?

Hélas non !

Avez-vous déjà essayé de parler à un ordinateur ou de faire en sorte qu’il reconnaisse votre voix ? Ça marchouille pour être positif mais ça reste très primaire ! De toute façon, il aura au mieux une compréhension syntaxique mais en aucun cas une compréhension sémantique même si certains chercheurs travaillent dans ce domaine.

Je ne parle même pas de la reconnaissance d’écriture, la bonne blague !

L’homme doit-il s’adapter à l’ordinateur ou l’ordinateur à l’homme? Telle est la question!

Jean-André Deledda, pour Cuk.ch

Mais le plus choquant est l’extase que certains manifestent sur la rapidité de traitement d’un micro ordinateur alors que le plus rapide des plus rapides à destination du grand public est un escargot endormi !

L’usage d’une suite bureautique ? On parle de dizaines de secondes pour le lancement ou la manipulation de documents simples !

Le développement de photos ? 8s avec Lightroom, plusieurs dizaines de secondes avec DXO si l’on en croit François qui reconnait à demi-mot qu’un peu plus rapide se serait bien et acceptant malgré tout cette lenteur, parce que bon, c’est plein de trucs compliqués un développement Raw.

Encoder une vidéo de 60mn dans le format de son choix ? Et bien, généralement 30 à 60mn !

Manipuler une image (rotation, filtres…) ? Généralement plusieurs secondes d’attente dès que l’image fait quelques centaines de mégaoctets.

Copier 10Go de données ? Plus d’une minute avec des supports dits rapide comme un disque dur.

Sauvegarder 4Go de données ? Plus de 10 minutes avec des supports dits « lent » comme un cédérom.

Faire du traitement vidéo en HD ? Plusieurs minutes d’attente de calcul de rendu.

Calculer une scène 3D réaliste pour une animation, un jeu vidéo, une simulation ? De plusieurs jours à plusieurs semaines de calcul !

Mais que diable, c’est cela qui émerveille tant les foules ?

Mais, l’instantanéité devrait être la base naturelle du « rapide ». Attendre une seconde devrait être lent. Attendre une minute devrait être pitoyable. Alors quand il s’agit d’heure ou plus, ne me parlez plus de performance !

Peu importe la complexité sous-jacente pour l’ordinateur ou la difficulté technique que cela représente. L’utilisateur ne veut pas savoir le miracle technologique du démarrage de sa voiture, il veut juste tourner la clé et que ça démarre !

Peut-on raisonnablement penser avoir dépassé le stade de la préhistoire alors même qu’aujourd’hui le moindre traitement parallèle (copier des données, décompresser des archives et lancer une vidéo) peut mettre à genou l’interface d’ OS X (curseur avec la roue couleur arc en ciel) alors même que les processeurs ne sont pas occupés à 100%?

Ah, la belle intoxication intellectuelle générale qui a permis d’ancrer dans les esprits :

- qu’il était normal d’attendre le lancement d’un logiciel (d’ailleurs maintenant, on vous expliquera qu’il est normal, sur une télévision avec TNT ou cable, d’attendre 1s entre chaque changement de chaine avec une télécommande alors que c’était instantané il y a 20 ans !)

- qu’il est normal d’installer et de désinstaller un logiciel ;

- qu’il est normal de défragmenter un support de stockage ;

- qu’il est parfaitement normal d’avoir un antivirus, un antispam, un antitroyen, un antitruc et un antimachin ;

- qu’il est normal qu’un logiciel bug, qu’il faille redémarrer un ordinateur tous les jours ;

- ...

Et, je ne parle même pas des bugs ou des incohérences les plus basiques que l’on retrouve à tous les niveaux dans tous les systèmes d’exploitation grand public !

Ici un exemple de message d’erreur abscons du Finder quand on tente de déplacer un sous-dossier au niveau supérieur de l’arborescence qui contient un dossier du même nom !

Au royaume des aveugles…

Mais vous me dites, aujourd’hui on a des stockages en To alors qu’on parlait de Mo il y a 20 ans ! On a de la vidéo en 1920×1080 !

La belle affaire ! Avec le blueray (simple face), on a un contenu de 25Go. Très vite, ce sera des centaines de To qui seront nécessaires pour stocker films, données, programmes… A moins que le vraiment (mais alors vraiment) très haut débit ne s’impose dans les années à venir pour fonctionner en mode « connecté ».

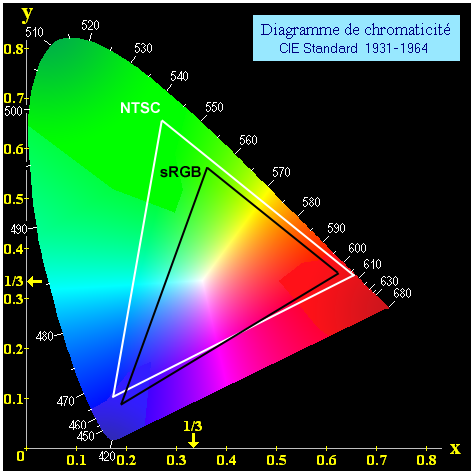

Pour la vidéo HD, 1920×1080, c’est 2 millions de pixels ! Même un néophyte peut se rendre compte que c’est ridicule comparativement à un appareil photo. Certes ce n’est pas le même usage, mais ne me parlez pas de technologie du futur avec des écrans 2MP ! Je n’ose même pas parler de la colorimétrie puisqu’un écran va souvent au mieux couvrir 100% du spectre NTSC, ce qui reste ridicule au regard de la gamme de couleur visible par un être humain :

La couverture du spectre visible par un écran est ridicule par rapport à la perception de l’oeil humain!

(Source : Wikipedia.org)

Finalement, en y réfléchissant bien, nous sommes aujourd’hui capables de faire de la musique numérique dont la richesse d’enregistrement dépasse la limite de la perception humaine. La musique numérique est mature.

Par contre, rendez-vous compte le chemin restant à parcourir pour l’image ? Respect des couleurs, couverture totale des couleurs visibles, densité des pixels, angle de vision, perception 3D comme le réel… L’image est le parent pauvre de l’informatique même si aujourd’hui on a l’impression que la qualité est formidable. En fait, la qualité est à mille lieux de ce qu’il sera possible de faire dans les années à venir !

Je ne parlerai même pas des interfaces faisant appel au toucher, à l’odorat et au gout. Nous n’en sommes encore qu’aux balbutiements (avec un léger avantage pour le tactile).

La maturité, c’est pour quand ?

Pour être visionnaire, je dirai que la maturité informatique sera atteinte dès lors que les étapes suivantes seront franchies :

- Rapidité : L’utilisateur n’attendra pas plus d’un dixième de seconde pour chaque action « simple » demandée à l’ordinateur. En fait, le concept de système d’exploitation temps réel sera la base de tout système grand public ;

- Fiabilité : Toute fonction/tache donnera le résultat attendu ;

- Robustesse : Toute erreur/problème est géré par l’ordinateur, pas par l’utilisateur ;

- Simplicité : L’interaction avec un ordinateur sera aussi intuitive qu’avec un humain ;

- Capacité : La limite de stockage ou le temps de calcul seront des concepts théoriques qui n’auront pas d’impact sur un usage « normal », les capacités étant virtuellement illimitées au regard des traitements demandés par un utilisateur « normal »

Oui, je sais cela parait très futuriste mais tout cela n’est pas utopique, loin de là.

Les processeurs quantiques pourraient être une clé à une vraie puissance informatique de calcul.

Le stockage holographique permettrait enfin de s’affranchir des barrières d’échelles.

Les disques SSD seront peut-être la solution à une vrai rapidité des transferts de données même si l’on est encore loin des To de débit.

La fiabilité, la robustesse et la simplicité ne seront que la conséquence de la maturité d’une science qui au terme d’un long processus d’apprentissage aura mis au point des matériels et des logiciels aboutis et performants !

Alors, bien malin qui pourra dire quand cela sera possible mais je reste intimement convaincu que ceux qui regardent en rigolant un ZX 81 cadencé à 3,25 Mhz avec ses 1ko de mémoire vive seront victime de la même moquerie par les possesseurs de micro-ordinateur en 2050.

Et vous, comment imaginez-vous l’informatique de demain ? Pensez-vous comme moi que nous en sommes qu’aux balbutiements ? Et, finalement, êtes-vous vraiment satisfait de la soit disant facilité et puissance des micros ordinateurs actuels ?

Compte tenu de l’orientation technologique des lecteurs, en cette nouvelle année 2009, rêvons un peu de l’avenir informatique! Merci d’avance de vos commentaires et de vos liens sur les technologies qui feront les ordinateurs de demain.

Bonne et heureuse Année 2009 à tous les cukiens !

, le 08.01.2009 à 00:11

Bonjour monsieur Azimov et les trois lois de la robotique !

Enfin… dans quelques décennies, si nous ne nous sommes pas vitrifiés, gazés, pollués ou noyés d’ici là !

Plus près de nous je pense que la deuxième ère de l’informatique a commencée avec l’ifaune qui concurrence déjà les téléphones et les pda et qui demain concurrencera les portables avec son interface très différente, ie, un écran tactile multi points, des accéléromètres et leurs multiples artéfacts interactifs… avec évidement une palanquée de logiciels gratuits ou payants.

A suivre donc !

, le 08.01.2009 à 00:33

Pour la prospective dans ce domaine, je vous conseille cette conférence de Michel Serres à l’X en 2005 ainsi que les sites suivants, soit le site Interstices ainsi que le site InternetActu entre autres sources, mais Guillôme doit en avoir d’autres en sa besace !

, le 08.01.2009 à 01:56

Cher Guillôme, je ne peux qu’être d’accord avec toi. Je dirai que ce n’est pas tant l’attente qui pose problême (les lois de la physique seront toujours là pour le rappeler) mais l’action en elle même. Un ordinateur n’est tout simplement pas accessible au premier venu tant il véhicule des concepts abscons. Il faudra un effort considérable à ce niveau là pour aller de l’avant. Et comme tout devient informatisé, c’est bien évidemment sur l’interface homme-machine que l’enjeu se porte. Sans faire le troll de base, j’ai toujours pensé que la domination de Microsoft dans ce marché a fait beaucoup de tort à l’innovation sur ce point. Cela aurait sans doute été de même si IBM était à cette place (leurs dirigeants de l’époque ne croyant pas au marché du micro ordinateur) ou même Apple. Ce que l’on voit actuellement avec les fondeurs de microprocesseurs n’est pas très bon pour faire avancer les choses n’ont plus. Tout cela pour dire qu’il faut continuer à faire des efforts pour rendre les choses plus simples au plus grand nombre, c’est à mon sens l’avenir proche de la microinformatique.

, le 08.01.2009 à 03:28

Également d’accord avec toi, mais je crois que le véritable enjeu est plutôt la capacité de produire en masse et à bas prix. Les technologies de nos machines de demain sont déjà là.

On peut aussi se demander si, dans un monde de plus en plus agité (problèmes écologiques, recherche de nouvelles sources d’énergie, surpopulation, modèle économique branlant, etc.), la priorité doit-elle être donnée au développement technologique. Pour ma part, je ressens de plus en plus la dépendance à la technologie comme une forme d’aliénation, d’ailleurs intimement liée à notre consumérisme pathologique.

Je pense aussi qu’un frein humain existe car nous en sommes encore à l’heure où les outils techniques sont, pour la plupart d’entre eux, des pièces rapportées. La “symbiose” homme-machine, si chère à la science-fiction, n’est pas encore d’actualité. Je suis toujours sidéré de voir le nombre d’utilisateurs de l’informatique qui se limitent au “presse-bouton” mécanique, sans la moindre compréhension logique de leur outil.

, le 08.01.2009 à 07:15

Ah le ZX 81, mon premier ordinateur, que j’en étais fier à l’époque. Qu’est-ce que j’ai pu passer comme temps dessus. J’avais le luxe de disposer d’un clavier indépendant et d’une extension RAM de 20 Ko donc la connexion était tellement sensible qu’il ne fallait pas heurter le bureau sinon l’ordi se figeait. C’est vrai qu’il y a un monde avec les ordis actuels.

, le 08.01.2009 à 07:26

Il me semble que l’évolution ne s’arrête pas et que, par conséquence, on est toujours au milieu du chemin.

Aussi, je me demande ce que signifie normal…

@+

, le 08.01.2009 à 08:22

Peut être que les humains mettent aussi à chaque fois la charrue avant les boeufs. Je veux dire par là que mon ordinateur d’aujourd’hui (un mac pro 8core avec 4Go de ram) aurait eu une puissance monstre pour faire tourner l’informatique d’il y a quelques années (à l’époque de windows 2000 et des divx par exemple, encore mieux avant).

Forcément aujourd’hui, même avec une telle machine, il y a la HD, mon film classique qui avant faisait 700Mo (un divx) fait entre 4 et 15Go (un bluray rip). La puissance nécessaire et l’espace dique requis sont donc bien différents, la bande passante également.

Ce sont peut être les technologies autour de l’informatique et les évolutions du software qui vont bien trop vite pour l’évolution du hardware par rapport à un niveau idéal entre les 2 ?

Dans tous les cas je suis bien d’accord avec toi, on en est encore qu’aux balbutiements, idem pour Internet ;)

, le 08.01.2009 à 08:24

Je sens la boutade qui me monte au nez.

Ben purée… si il y a autant de malentendus avec les ordinateurs qu’avec les humains, moi, je préfère encore la souris. ^^

Ce n’est qu’à moitié une boutade.

, le 08.01.2009 à 09:31

Guillôme je vous trouve bienveillant. Ce qui se cache derrière votre “ère paléolithique” c’est tout simplement de l’obsolescence. D’autant plus que certaines techniques qui permettraient de “rajeunir” nos compagnons électroniques sont connues depuis des lustres.

BINAIRE

D’où proviennent toutes ces limitations ? Personnellement je me demande s’il ne faudrait tout simplement pas mettre aux orties le système binaire, ou – moins violent – l’améliorer. Ce que font déjà les ordinateurs quantiques (et leur qubit), toutefois il n’est toujours pas certain que ce type d’ordinateur puisse révolutionner l’informatique : la plupart des tâches réalisées par un ordinateur classique n’iraient pas plus vite sur un ordinateur quantique. Une piste intéressante seraient de remplacer le système binaire par le système ternaire. Peu connu chez nous (littérature pratiquement inexistante), il est utilisé par les russes.

VERS HAL 9000

D’ailleurs, on retrouve étrangement cette notion de 3 états dans le concept de Machine de Turing à Oracle (vous savez, Alan Turing, le fondateur de la science informatique). Ces oracles seraient capables de répondre à n’importe quelle question en un temps quasiment nul. Une légende veut que Turing ait trouvé le moyen de mettre en oeuvre un tel Oracle (note en marge d’un manuscrit) sans en décrire le détail de conception. Voilà peut-être le Graal du nouveau siècle.

Kub.

p.s. Cette histoire d’Oracle me rappelle un épisode du Prisonnier. Dans cet épisode il fait face à un ordinateur capable de répondre à tout. Notre prisonnier le bloque en lui posant une simple question : “Quoi ?”. Si mes souvenirs sont bons.

, le 08.01.2009 à 10:02

J’y repense. À propos du ZX 81. On pouvait faire des miracles avec ces machines. Anecdote (véridique) : En France c’était l’époque de l’informatique pour tous (année 80). J’étais collégien et mon école disposait de quelques ZX81.

Je passais le temps du déjeuner à écrire un programme de reconnaissance vocale (!) en BASIC (!!) en utilisant le microphone du magnéto cassette (!!!).

Vint le moment de tester le programme. Je me penche vers le microphone et je sors un long AAAaaaaa. Là je vois l’écran qui flash, devient noir et se rallume. Mémoire vide, mon programme a disparu (mes deux dernières heures de boulot n’ayant pas été sauvegardées sur cassette).

Que s’est-il passé ? Il faut rappeler que les touches du clavier permettait d’accéder à des fonctions du BASIC. La touche A était associée à la fonction NEW, laquelle efface la mémoire. En prononçant Aaaa j’ai activé cette fonction. Pif paf, plus rien.

Mon programme a fonctionné qu’une fois. J’ai été incapable de le réécrire…

(Autre explication : le son transmis par le magnétophone a tout fait planter, mais je ne veux pas croire que je sois si mauvais programmeur :-)

Tout ça pour dire qu’on ne tire pas assez de la puissance disponible sur nos machines, elles pourraient certainement faire bien plus et mieux que ce qu’elles proposent aujourd’hui : c’est aussi une question de logiciel.

Kub.

, le 08.01.2009 à 10:05

euh… et pratiquement, ça se passerait comment avec un système ternaire? En binaire, le courant passe ou ne passe pas (1 ou 0). En ternaire, on ajoute quoi? le courant passe un peu?

Simple curiosité…

, le 08.01.2009 à 10:15

Voici un article bien intéressant. Mais je pense tout de même qu’il y a eu une transition dans le sens ou l’informatique est devenue utile à tous. Il y a 30 ans, notre monde tournait déjà tant bien que mal mais sans l’informatique. De nos jours, même mes parents utilisent leur iMac, accèdent à leur banque via Internet, prennent des photos avec leur GSM,… Le ZX-81 ou l’Apple II étaient souvent des jouets de luxe. Maintenant, les enfants doivent faire des travaux sur ordinateur en se connectant à d’autres ordinateurs. On vit avec les ordinateurs . Qu’on le veuille ou non. ()

Je pense également que l’informatique est un domaine ou le principe de pareto est tiré à son extrême. Avec 5% des performances du nouvel iMac on arrivait déjà à 95% des résultats. Oui, la page imprimée était moins jolie mais le contenu de la lettre y était tout aussi lisible.

Passer d’une résolution de 320×240 à 640×480, c’est énorme. C’est la différence entre la machine de jeux et l’ordinateur avec lequel on peut travailler. Avec 320×240 on ne peut pas afficher 80 caractères par ligne correctement. Avec 640×480, le traitement de texte ou le tableur deviennent possibles. Avec 230000 pixels en plus.

Le passage de 640×480 à 1280×960 est une grand évolution mais cela ne permet pas pour autant des fonctionnalités totalement nouvelles. Pourtant on a rajouté 921000 pixels !

C’est la même chose pour la TV. Notre bonne vielle simple définition est +/- 720×576. La HD nous apporte le 1280720 et le Full HD le 19201080. On a multiplié le nombre de pixels par cinq ainsi que le flux vidéo associé. Mais l’image est-elle cinq fois mieux ? C’est sensiblement mieux mais voir les boutons du présentateur ne change pas la vie. La vrai révolution, c’est le jour ou mes grand-parents sont passé de la radio à la TV.

Comparons Word 97 avec Word 2007. Dix ans et des centaines de megaoctets d’écart… Je dois écrire un document de 5 pages. Qu’est-ce qui change ? Quelles sont les nouvelles fonctionnalités de Word 2007 qui sont indispensables et qui font toute la différence avec l’ancienne version ? Est-ce plus rapide ? Même sur mon MacBook Pro ?

C’est pour cela que j’ai de l’admiration pour certaines innovation d’Apple. Ce qui est cool dans l’iPhone ce n’est pas tant ses caractéristiques techniques mais la manière dont le concept a été pensé. On sent qu’il y a eu une réflexion du style : on part d’une page blanche, les gens veulent un GSM, comment en faire un objet pratique ? Quelles sont les technologies disponibles ?

Chez Nokia, Sony-Ericson, ou encore LG, ils en étaient à se poser des questions différentes : sur le nouveau modèle, on met le clavier un peu plus haut ? On va pas un peu changer la forme des touches ?

() Il faut tout de même se rappeler qu’il y a la plus grande partie de la population mondiale qui vit sans accès à internet, à l’ordinateur, à l’électricité, à l’eau courante,…

, le 08.01.2009 à 10:34

Bah, je ne pense pas qu’on nous regardera de haut en 2050, mais tout comme nous remercions un Steve d’avoir retenu par cœur l’OS de l’Apple I, nous serons remercié de notre passion qui a permis à l’informatique de progresser.

Dans un système ternaire, on a -1, 0 ou 1 ; le courant ne passe pas, passe dans un sens ou dans l’autre. Voir Wikipédia (en anglais)

, le 08.01.2009 à 10:35

Je ne sais pas comment ce serait en ternaire au niveau logique, mais en binaire, la réalité est un peu différente que courant / pas de courant. Il s’agit plutôt d’une plage de courant faible pour le 0 et d’une plage de courant plus élevé pour le 1.

Je me dis la même chose. Dans 100 ans on (ils plutôt) se dira que ce qu’on a aujourd’hui est complètement dépassé, en se demandant comment on pouvait vivre avec, mais on pensera encore et toujours que l’on peut faire largement mieux…

Le fait que c’est tout un environnement qui évolue ne permet pas de comparer un élément isolé au cours du temps. Exemple; bien sûr que les disques durs ont beaucoup augmentés de taille, mais l’utilisation a également changé: les images sont de meilleures qualités, donc plus grandes, pareilles pour la vidéo, la musique se met sur nos ordinateurs, on fait des présentations pleine de jolies images, on installe plusieurs systèmes à la fois, etc…

Quant à la maturité informatique dont parle Guillôme, je ne suis pas sûr qu’elle soit atteinte un jour… Ou du moins pas complètement. Notamment dû à cette constante évolution d’un environnement dans son entier comme je viens de le dire.

Rapidité: Ca ira plus vite, mais pour plus de choses, et plus complexes. Pour certaines tâches, il y aura donc un réel gain, pour d’autres pas, simplement la qualité sera meilleure. Et finalement, le concept du système d’exploitation temps réel grand public, pas certain… Et d’ailleurs, temps réel ne signifie pas “tout en même temps”, mais plutôt “ordonnancement sous certaines contraintes”. Pour arriver à du vrai parallélisme, le seul choix et de dédier un processeur par tâche.

Fiabilité: Les systèmes deviennent plus complexes, donc on améliore certaines choses, mais les nouvelles comportent également leurs problèmes.

Robustesse: Sans doute un point important, mais souvent le plus gros problème est l’utilisateur lui-même ;-)

Simplicité: A mon avis un des points les plus difficiles et pourtant extrêmement important.

Capacité: Là aussi, cela peut être amélioré, mais si tout ce qu’on stocke sur un disque augmente de taille également, ce n’est pas joué d’avance.

En résumé, beaucoup a été fait, énormément reste à faire.

, le 08.01.2009 à 10:38

Je dirai plutôt inhibé pour le troisième état. Un peu comme les neurones : excité, pas excité, inhibé. Fondamentalement cela introduit de nouvelles fonctions logiques à celles utilisées dans nos machines (issues de l’algèbre de boole : fonctions ET et OU par exemple).

, le 08.01.2009 à 10:58

Au risque de vous gaver avec mes références et mes conférences èmpétroïsées, voici une autre conférence de Michel Serres (encore lui, je sais, mais tous les conférenciers n’ont pas son talent de conteur, ni son accent, même si Janco se débrouille très bien avec ces petites blagues) qui donne le recul nécessaire et la vision globale obligatoire que l’on devrait avoir de tout problème qu’il fut technique ou sociétal.

Bonne écoute !

, le 08.01.2009 à 11:11

Merci alec6, première fois que j’entends parler de Michel Serres (heu je ne sors pas beaucoup de Chine, même par internet, voyez vous), et, c’est bien, très bien. Merci de me l’avoir fait découvrir. Treeeees intéressant tout ça, et merci Guillome pour ce billet.

, le 08.01.2009 à 11:13

Imagine un périphérique de stockage. Aujourd’hui, une zone est soit dans l’état 1, soit 0. Or, pour avoir travaillé dans les nanostructures, on peut tout à fait imaginer une molécule ou un cluster d’atomes, pouvant avoir un état par orientation dans l’espace. Chaque orientation aurait alors un comportement différent devant son interaction avec de la lumière ou un courant électrique.

Cela augmenterai grandement la capacité des dispositifs de stockage.

Pour les processeur, tout est à revoir. Toute la logique (AND, OR, XOR, NAND, NOR) est faite pour le binaire et doit donc être réinventée. Quel beau projet, non ?

, le 08.01.2009 à 11:24

Merci à tous pour vos réactions :)

Je note que vous réagissez beaucoup plus sur le futur de l’informatique actuelle et sa maturité que sur sa capacité actuelle à répondre aux besoins de l’utilisateur qui est source d’insatisfaction pour moi.

Je ne suis pas forcément d’accord. La limite est celle de nos sens, du moins en ce qui concerne l’image, le son, le toucher…

Actuellement, si l’on excepte les concepts de spatialisation du son en 3D, nous sommes arrivés à la limite du son. Nous pouvons traiter et produire du son qui dépasse la qualité maximale perceptible par un être humain (je ne parle même pas du fait que la majorité se contentent de mp3!).

Concernant l’image, quant on sera capable de faire un écran qui couvre tout le spectre visible par l’humain avec une résolution supérieure au pas visible par l’oeil, on n’aura pas besoin d’aller plus loin!

Les seuls infinis sont à mon avis la puissance de calcul et le stockage. Le premier peut être résolu en démontrant qu’un problème NP Complet est réductible à un problème polynomial. Le deuxième a peut être une issue dans l’existence de l’infiniment petit…

Je suis d’accord avec toi :D mais moi je demande la simplicité de l’interaction pas la fiabilité de l’interaction ;)

Aujourd’hui, on a aucun des deux, c’est compliqué et en plus quant on clique il arrive que ça plante, ça fasse un truc différent, ça ne fasse rien…

Je ne pense pas.

Un bug, un plantage, une erreur fonctionnelle… Est-ce une inadéquation matériel/logiciel? Non, il s’agit d’une science non mature du logicielle qui ne permet pas de développer sans erreur (ou autrement dit, une automatisation inexistante pour prendre en charge la qualité logicielle qui est trop couteuse à traiter manuellement).

Une consommation de la mémoire ou du processeur trop importante, un algorithme inefficace… Est-ce une inadéquation matériel/logiciel? Non, plus, il s’agit d’un savoir sur les techniques de programmation qui est encore à la recherche de la technique idéale de conception… Il reste à inventer l’atelier de développement ultime (comme l’a tenté NextStep).

, le 08.01.2009 à 11:49

Tout à fait (quoique je dirai plutôt “capacité” de stockage). À titre de comparaison, un octet binaire (8 bits) permet de stocker 256 valeurs différentes (2 puissance 8). Son équivalent ternaire (8 tits dirons nous) permet de stocker 6561 valeurs différentes (3 puissance 8)…

K.

, le 08.01.2009 à 12:09

Je préfère Bouveresse à Serres

, le 08.01.2009 à 12:33

Moi je veux un ordinateur à processeur Zen. Qui diffuse de la zenitude… et qui plante zenement. C’est tout.

, le 08.01.2009 à 12:33

Certes Kermorvan, mais Serres est peut-être meilleur épistémologiste que Bouveresse sur ce sujet là du moins… et sûrement moins bon polémiste…

, le 08.01.2009 à 12:41

Juste pour le fun, une comparaison de rapidité sur des tâches courantes ici (réalisées dans Word et Excel) réalisée il y a deux ans entre un MacPlus et un AMD. Dans 53% des cas le MacPlus bat la machine récente.

Si le progrès nous fait gagner en efficacité sur certains point on en perd sur d’autres, alors ? Deux pas en avant, un en arrière ?

, le 08.01.2009 à 13:14

alec6, ce n’est peut-être pas ici le lieu d’entrer dans la querelle, mais Bouveresse répond clairement, c’est tout autre chose comme niveau de réflexion.

, le 08.01.2009 à 13:56

Pour revenir sur le système ternaire ou plus (rien n’empêche d’utiliser d’autres bases en théorie), il faut noter que cela implique une complexité supplémentaire à la base de tout, à savoir la gestion électrique. Soit il faut utiliser diverses tensions d’entrée (en binaire sur du TTL standard on fonctionne à 5V: le 0 est considéré comme un zéro entre 0 et 0.9 V et le 1 à partir de 3.3V jusqu’à 5V. Les valeurs entre les deux ne doivent pas exister car cela engendre des erreurs et donc on ne peut prédire si cela va être un 0 ou 1).

En ajoutant un état, il est nécessaire soit de travailler avec des tensions négatives soit des tensions intermédiaires entre deux positions extrêmes. Cela peut engendrer des erreurs (niveau électrique). Par ailleurs, plus la fréquence de travail est élevée, plus il faut baisser la tension de fonctionnement (actuellement les processeurs fonctionnent bien plus bas que 5V, pour éviter des systèmes de refroidissement énormes), ce qui engendre de ce fait des plages d’interprétation des valeurs encore plus serrées. On risque alors de passer plus de temps (temps de disponibilité du système de calcul) à corriger les erreurs.

Cela pour dire que si sur le papier c’est une voie intéressante, dans la réalisation, c’est autrement plus ardu.

, le 08.01.2009 à 14:16

Je comprends bien, et si l’on se focalise sur certains points uniquement, on est bien d’accord qu’il y a une limite. Ce que je veux dire, c’est que dans l’ensemble, on trouvera toujours quelque chose à améliorer. D’abord une technologie précise; lorsque celle-ci est proche de la limite, alors c’est un autre domaine peut-être inconnu jusque-là qui prend le relai.

Ca rejoint ce que tu dis dans l’article et que j’appuie totalement: C’est pour cela que j’ai de l’admiration pour certaines innovation d’Apple. Ce qui est cool dans l’iPhone ce n’est pas tant ses caractéristiques techniques mais la manière dont le concept a été pensé.

Facile ;-)

, le 08.01.2009 à 18:18

Depuis quand Intel et les autres sont-ils sur le marché pour nous rendre service ?

Leur seul but is $$$

, le 08.01.2009 à 19:31

Il y a qq année je pensais qu’une fois que les machines pourraient lire la vidéo en temps réel, on serait à un palier.

Puis la HD est arrivée et on parle déjà de super HD. Plus tard l’hyper HD en 3D Holographique temps réel… Hier, Apple à annoncé la reconnaissance des visages pour iPhoto et un jour dans les vidéo probablement. Plus tard la reconnaissance d’objet, de lieux, de monument, des gestes…

Ce ne sera jamais fini.

Sauf si peut-être on atteint une limite, mais laquelle ? Limite des hommes pour développer des algorithmes efficace ? limite des machines en puissance ?

, le 08.01.2009 à 19:55

Je rajouterai deux critères : – écologique – non nuisible pour la santé (avec les nano-technologies, ça a l’air mal barré)

Outre Michel Serres, il y a aussi Marcel Gauchet ( http://gauchet.blogspot.com ), philosophe et historien qui livre des réflexions pertinentes sur l’extériorisation du savoir, la désintellectualisation des sociétés où l’individualisation prime sur l’acquisition d’un savoir et d’une culture. Pour amateur de réflexions plutôt que d’encyclopédie en ligne…

, le 08.01.2009 à 20:39

Moi, il y a toujours les mêmes choses qui m’agacent : Les critiques envers l’utilisation des logiciels informatiques. Je programme moi-même, et ce n’est vraiment pas simple de faire simple. Et c’est très coûteux en temps de développement. Tout de même, il y a une certaines logiques, le menu Fichier s’appelle toujours Fichier, et Ouvrir est toujours dans ce menu Fichier, et c’est logique vu qu’on ouvre un fichier.

Quand je compare ça à la langue Française, et souvent les premiers à critiquer l’utilisation d’un logiciel sont les premiers à faire des remarques sur la grammaire et l’orthographe. Alors quand la langue Française aura aussi peu d’exceptions que les interfaces informatiques ils pourront râler. Pourquoi le nombre 1000 ne s’écrit t’il pas mile ? Moi aussi je vais m’amuser dans mes programmes à ce que le menu Fichier – Ouvrir fasse en fait Edition – Coller. Le menu Quitter lancera une autre application, comme ça pour faire une exception, j’avais rien à foutre et je me suis dit “tiens, j’vais faire original !”. Le pire, c’est que si je fais ça avec mes logiciels Freeware, je suis sûr qu’il y en aura pleins pour se permettre de m’envoyer un email avec une remarque. Putain, quand je fais ses dictées de mots à ma fille de CE2 et qu’elle me demande (bien trop souvent) pourquoi tel mot s’écrit comme ça alors que si on le prononce tel qu’écrit ça sonne autrement …

Bref, certains jeunes gonflés par toutes ces exceptions chiantes se sont créer leur propre langage (SMS). Créez vous VOS logiciels avec VOS interfaces ! L’outils est gratuit et est fourni avec Mac OS X, il s’appele X-Code.

Pourquoi ce coup de gueule ? Parce que quand un gosse fait une faute d’orthographe logique (écrire mile) on l’engueule, et c’est lui le con. Quand un type fait une fausse manip sur un logiciel parce qu’il clique Ok sans rien lire des messages, c’est l’auteur du logiciel le con !

Vous êtes des UTILISATEURS de logiciels et avaient le droit de faire des remarques sur les logiciels que vous utilisez ? Je suis un UTILISATEUR de la langue Française. Ca ne vous fait pas bander de savoir comment est fait un logiciel ? Vous voulez juste l’utiliser le plus rapidement possible ? La langue française ne me fait bander non plus, je veux juste communiquer le plus rapidement possible !

Je ne me relis pas, vous avez le droit de me faire une remarque sur l’orthographe de ce message A CONDITION de mettre un lien vers un de VOS programmes !

, le 08.01.2009 à 20:57

Enfin le temps de répondre…

Merci pour cet article.

Je me suis toujours dit, quand je reprends des vieilles machines que j’envoie à je ne sais qui via la déchetterie, que ces Macs qui font sourire maintenant nous ravissaient il y a dix ans. Que nous les trouvions beaux, géniaux, designs (ces iMacs émeraudes, ça plaisait, c’est dingue)…

Que pensera-t-on dans dix ans des iMacs Aluminiums?

La même chose que ce qu’on pense maintenant d’un Performa…

De toute façon rien de grave, c’est juste rigolo, et il faut en être conscient.

, le 08.01.2009 à 22:26

Plusieurs choses, Tom25 :

et effectivement, c’est vraiment pas simple de faire simple et loin de moi l’idée de critiquer le programmeur, je le considère plutôt comme une victime!

s’écrit-il

L’outil (…), il s’appelle X-Code

Bah, dateconverter :p

, le 08.01.2009 à 23:23

Pas forcément. Bien qu’on en soit encore loin, on peut imaginer qu’à l’heure où il est déjà possible de remplacer certains morceaux du corps humain ou de modifier génétiquement des organismes, la porte est ouverte à de nouvelles IHM. L’idée du “cyborg” a déjà un demi-siècle…

, le 09.01.2009 à 07:33

Ce n’est pas toi que j’attaquais Guillôme, je réagissais aux remarques que j’entends dans mon entourage, aux commentaires des utilisateurs sur différents sites (VersionTracker, MacUpdate, etc.).

Ceux qui maîtrisent très bien la langue en profite bien souvent pour s’élever aux dessus des autres. Tu le fais en rigolant plus haut, mais c’est exactement ça. Pourquoi en tant que programmeur je dois me casser le cul pour rendre mon logiciel simple, et en tant qu’utilisateur de la langue je dois perdre mon temps à apprendre toutes ses incohérences ? Il y a un certain sentiment élitiste chez beaucoup de ceux qui maîtrisent la langue, et souvent ils sont agressifs ou moqueurs envers ceux qui ne la maîtrisent pas. Ce qui me gêne, c’est que concernant l’informatique, les mêmes personnes se moquent de ceux qui savent l’utiliser.

Un gars qui ne sait ni lire ni écrire, ou mal, sera quasiment toujours en bas de l’échelle. Jamais il n’a été question de remodeler quoi que ce soit pour lui rendre l’accès à sa langue plus simple. Alors pourquoi diable parle t’on autant de rendre l’informatique simple, à la porté de n’importe quel abruti ? Laissons l’informatique aux gens doués dans ce domaine. Ou alors faisons les mêmes efforts partout.

Ca me fout les boules que ma fille soit encore en train d’apprendre une liste de mots invariables à la con au lieu d’être en train d’apprendre une langue étrangère. Mais si on défend le “patrimoine” de la langue, alors je m’érige en défenseur du maintien de la “complexité” actuelle de l’informatique. On doit faire des efforts pour les uns et pas pour les autres ?

, le 09.01.2009 à 08:12

Hummm, la langue n’est pas seulement un outil de communication, mais également un vecteur culturel. Ses finesses, ou “incohérences” si tu préfères, ont un sens, tout comme l’art a un sens. L’informatique n’est qu’un outil, au même titre qu’un ustensile de cuisine ou un véhicule. Une langue évolue et se charge de sens au fil de son histoire alors qu’un outil finit à la poubelle lorsqu’il est usé ou dépassé. Je trouve ta comparaison quelque peu curieuse !

, le 09.01.2009 à 09:58

@Tom25. Cher Tom, un petit programme de calcul de la transformée de Fourier discrète, en dimension n, n=2^p; n est porté dans la mémoire N; le tableau X porte initialement les coefficients du polynôme dont nous calculons le transformé; nous avons les puissances de a=exp(2i.PI/n) dans le tableau A; le programme substitue au polynôme son transformé, à ceci près que les coefficients sont alors présentés dans l’ordre imposé par le miroir Mir, Mir(q) est l’entier obtenu par passage au mot miroir dans la représentation base 2 sur p caractères; le produit des complexes est simplement noté ”.”;

T:=N; tant que T>1; T2:=T; T:=T/2; K:=N/T2; pour I de 0 à K-1; pour J de I.T2 à I.T2+T-1; R:=X(J); S:=X(J+T); X(J):=R+S; X(J+T):=A(I).(R-S); fin tout; \

Y a-t-il une faute dans mon programme ? Et maintenant, je renonce à relever quelque faute d’orthographe que ce soit.

, le 09.01.2009 à 10:13

Tom25 : si mille s’écrit avec deux L, c’est exactement pour le même type de raison que la fonction ouvrir se trouve dans le menu Fichier. Parce que, il y a quelques siècles, tout le monde s’est mis à écrire mille avec deux L. Donc c’était plus simple de faire comme ceci, que de devoir tout faire réapprendre à tout le monde. Il y a plein d’orthographes bizzaroïdes qui sont des moyens mnémotechniques (mnémo- car la déesse grecque de la mémoire est Mnémosyne, ça aide quand à l’époque tout ceux qui apprenaient à lire avaient une culture gréco-latine).

Et maintenant, si on change l’orthographe, il faut aussi réimprimer tout les bouquins, et modifier tout les sites web avec la nouvelle orthographe, sinon, on n’aura plus nulle part où apprendre à lire.

, le 09.01.2009 à 10:25

Je suis supris de ne pas avoir lu de commentaire de Diego.

Come on dit à la télé, Diego, si tu nous lis ;-)))

, le 09.01.2009 à 10:35

Effectivement, pardonne-moi Tom25 mais j’ai du mal à te suivre, même si dans le fond je vois ce que tu veux dire. La langue est une évolution culturelle et pas l’oeuvre d’une ou un petit groupe de personnes comme un programme informatique dans le but d’améliorer notre rendement.

Et à quelque part, ça peut paraître injuste, mais l’utilisateur est roi face à un programme. C’est en tout cas ce que j’ai toujours pensé, et c’est comme ça que je vois les choses, au même titre qu’un client face à un architecte. Le programmeur peut guider l’utilisateur, vu ses connaissances du milieu, mais l’idéal serait que l’informaticien conçoive un outil qui soit le prolongement naturel de l’humain.

Et pour arriver à des interfaces comme le fait Apple, il faut justement pouvoir quitter cette vision d’informaticien pour se mettre comprendre ce que l’utilisateur veut. Et ensuite se débrouiller pour réaliser le programme.

Que l’on soit architecte, programmeur, concepteur de véhicules, etc…, c’est à mon avis une grosse erreur d’imposer à l’utilisateur sa manière de faire sans savoir ce qu’il veut et pourquoi il le veut de telle façon. Car les raisons du programmeur seront liées au développement, qui ne concerne en rien l’utilisateur final.

C’est la vie. Et c’est mon avis…

, le 09.01.2009 à 11:31

Intéressante cette digression sur le langage… Je ne suis ni scientifique comme Kermorvan, ni ingénieur comme Tom25, mais j’ai appris en sémiologie que la différence entre langage et communication réside dans le fait qu’un langage, du moins dans le sens de la linguistique est équivoque et non univoque comme peut l’être la communication.

En d’autres termes, une même phrase peut signifier plusieurs choses selon l’interlocuteur, selon ses connaissances, son milieu culturel… D’où les problèmes d’incompréhension, de contre sens ou de faux sens… Ne dit-on pas par ailleurs que c’est la phrase qui donne le sens des mots et non l’inverse ! Le texte donnant le sens des phrases, le contexte… etc.

En revanche la communication est donc univoque, l’information n’a pas de sens cachés et par des artefacts mathématiques, elle peut même être comprise indépendamment du sens de lecture comme les codes barres.

Kermorvan, peut-on appeler cela un “théorème d’incomplétude” ? Pauvre Goedel, un peut plus et son fantôme prendrait peur des vivants.

Quant aux interfaces, Apple a su faire un design global digne de ce nom, ie en mettant en avant l’usage, donc l’usager et non le décor. Malheureusement beaucoup de “créateurs” et je suis bien placé pour en causer, font d’abord de la façade et se foutent éperdument de l’usage et de l’usager. Ce qui n’est pas trop grave pour un graphiste et même un designer, car au pire leurs “créations” finissent à la poubelle du moins pour les réalisations éphémères, en revanche, cela devint plus grave avec des objets inutilisables, complexes ou inconfortables, voire dangereux et carrément scandaleux avec des architectures qui vont faire suer le monde pendant des décennies si ce ne sont des siècles comme la fameuse Bibliothèque de France ou les massacres à la bétonneuse dont l’Est parisien (entre autre sur la planète) s’enorgueillit depuis trente ou quarante ans. Quoi que, dans le cas de la magnifique Place des Fêtes à Paris dans le 19e, l’ensemble soit cohérent : mal conçu, mal construit, d’une laideur sans égale à la mesure du mépris des décideurs et con-cepteurs de l’époque !

, le 09.01.2009 à 14:36

Bonjour à tous et recevez mes meileurs voeux pour l’an 9.

Je vais essayer de répondre à la question principale posée dans l’avant dernier paragraphe par Guillôme.

Comme je suis assez nul en futurologie je vais faire appel à un artiste.

Dan Simmons, dans sa suite “Hyperion” propose une évolution des technologies informatiques qui, ma foi, me plait bien.

, le 09.01.2009 à 18:37

z

, le 09.01.2009 à 19:23

Z… p’tit jeune !

, le 09.01.2009 à 20:02

1 1 2 5 14 42 …

, le 09.01.2009 à 23:12

Heuu, non, rien à voir avec l’âge que j’aurais dans 6 mois…

QUARANTE–DEUX est tout simplement la réponse à La grande question sur la vie, l’univers et le reste, faite par “Deep Thoughts”, un ordinateur superpuissant après sept millons cinq cent mille ans de calculs, dans le “Guide Galactique” de Douglas Adams… A lire absolument si vous aimez rire !

J’aurais tout aussi bien pu citer “MACNO” (“Magasin des Armes, Cycles et Narrations Obliques”), du trop peu connu Ayerdhal, sans parler du bienveillant HAL 9000 de 2001…

Pour en revenir au sujet, je crois que “l’informatique grand public” n’en a plus pour très longtemps sous la forme que l’on utilise actuellement, l’ail faune étant les prémices de son futur : un truc multi–usages, très communiquant, très fermé (moins de bugs), la “station de travail” avec gros logiciels puissants devenant de l’usage exclusif de professionnels (vidéo, son, photo, 3D…).

z (et souvenez vous, je répêêêêêêêêête : QUARANTE–DEUX !)

, le 10.01.2009 à 09:20

Ceux qui maîtrisent la langue s’en servent souvent pour appuyer leur opinion et descendre celle des autres. Dernièrement, avec la gueguerre entre les deux PS, un du camp de Ségo a dit à propos d’un texte de l’autre camp : “bourré de fautes” ou un truc comme ça. Je ne veux pas débattre de l’importance des fautes dans un texte dans lequel on expose des idées, ni de savoir si les idées sont moins bonnes parce qu’écrites avec un texte bourré de fautes. Je veux dire qu’on agresse l’auteur du texte sur ce point. Pourquoi alors ne pourrait-on pas dire, de la même façon en balayant d’un revers de main le texte d’un autre : “tu ne l’as même pas écrit toi-même, tu ne sais même pas utiliser un clavier au XXI ème siècle”. Non seulement on ne le dit pas, mais en plus c’est celui qui se trouve incapable d’utiliser un des logiciels les plus simples qui agressent la communauté entière de informaticiens parce qu’ils conçoivent des trucs inbitable et nul à chier.

Mes filles, il leur a fallu 1 heure pour faire ce que ne font encore pas mes parents après 3 ans !

On me dit qu’on s’en fout des raisons du pourquoi du comment un logiciel est fait de tel manière, l’utilisateur n’a pas à savoir ce qu’il y a dedans. Je trouve simplement un peu facile de systématiquement reprocher à ceux qui connaissent l’informatique de ne pas la rendre plus accessible aux pas doués, tout en, dans le même temps, reprocher sans cesse à d’autres personnes de se planter dans des constructions illogiques de la langue française. Quand quelqu’un se trompe dans l’utilisation d’une fonction d’un logiciel, on le lui dit pas “mais putain t’es vraiment con, ça se fait comme ça !”. C’est ce qu’on dit à quelqu’un qui fait une faute. On pourrait lui dire “oui c’est une énième exception, c’est logique de l’écrire comme tu l’as fait”.

Je ne suis pas pour la réécriture de la langue française en SMS non plus. Mais j’en ai marre de voir les mêmes personnes mettre en avant leur savoir tout en dévalorisant celui des autres.

L’informaticien est le grouillot qui doit fournir un outil simple et qui fonctionne.

On ne fait quand même beaucoup d’effort pour les illettrés, si on faisait pour eux le dixième des efforts qu’on fait pour rendre l’informatique plus accessible ils seraient au paradis.

Je trouve souvent très pédants les gens qui maîtrisent la langue. Ce n’est pas parce que vous me prenez pour un con parce que je fais des fautes que moi je vous prends pour des cons parce que vous avez des problèmes avec l’utilisation d’un ordinateur. Alors arrêtez de stresser et de dire que tout ça c’est nul et mal fichu, soufflez un bon coup et apprenez.

Je dis vous, mais ce message aux personnes nommées en début de paragraphe.

Et Guillôme, je ne suis pas en désaccord avec les évolutions que tu décris. Je profite de l’occasion pour mettre le doigt sur des attitudes qui m’agacent.

, le 10.01.2009 à 15:02

Tom…

L’orthographe ? l’occasion d’instruire.

mille, adjectif ou substantif ? invariant ? (mille baisers)

mettre dans le mille

mil ou millet, fièvre miliaire, et même tumeur des paupières

le mile – ou mille – 1609 mètres

, le 10.01.2009 à 15:49

Moi, je trouve ABSOLUMENT GENIAL d’avoir trouvé une technique permettant de copier 4 Go sur un support “lent comme un CDRom”… Alors là chapeau bas, je sais pas faire ? Guillôme explique nous tout ça… allonges-toi… respire calmement… voilà, on est pas bien là ou bien ? Vas-y… lances-toi, on est toutes ouïes…

Bonne Fête à toi, Ami Guillôme… et encore BONNE ANNEE A TOUTES ET TOUS :-)

, le 10.01.2009 à 15:50

@ Kermorvan… je donne ma langue au chat, j’avoue que la suite 1 1 2 5 14 42 … m’est totalement absconse ! Au mieux je trouve pour chaque nombre : +0, +1, +3, +9, +28… mais pas de suite logique entre ces valeurs là. Si encore on avait 27 et non 28, mais se serait tout de même bancal.

Tu vois Tom, on maîtrise ce qu’on peut, ce n’est pas bien grave, les “intelligences” sont complémentaires si tant est qu’elles soient innées, mais avant tout elles sont le résultat d’un apprentissage, d’une éducation et des goûts ou phobies initiées par des parents, des proches ou des enseignants depuis son plus jeune âge. Et là… il ne s’agit plus d’intelligence mais de savoirs et de logique plus ou moins développés par des expériences et éléments extérieurs.

, le 10.01.2009 à 16:01

Bonne réaction, alec6 ! La suite de catalan est la plus célèbre de l’univers informatique. La suite des puissances de 2 est la suite exponentielle type: dénombrement des parties d’un ensemble fini. La suite des factorielles grimpe plus vite que la suite des puissances de 2: dénombrement des permutations d’un ensemble fini. La suite de catalan dénombre les arbres binaires tels qu’ils sont utilisés par les informaticiens. Taper le début de cette suite sur Google (notre ami), et ça donne le lien pour aller sur le site américain des suites d’entiers, hébergé par ATT (quand ça fonctionne, ce n’est pas le cas en ce moment, l’internet ne fonctionne pas si bien que ça aux E.U.).

, le 10.01.2009 à 16:08

Tom…

Un bon dictionnaire gratuit en ligne?

un widget pour le mac

un site de référence

et même une extension pour Firefox, si votre écran est assez grand, très bien sur un 24 pouces

, le 10.01.2009 à 16:32

Cher Tom… surtout ne t’énerve pas, ça n’en vaut pas la peine ! :-) C’est vrai – tu as raison – il est un brin urticant de constater que dans un débat d’idées l’orthographe soit mise trop souvent en avant pour se moquer, rabaisser voire détruire l’argumentation de quelqu’un alors que ses idées peuvent être tout à fait excellentes ! A côté de ça, je ne sais plus qui a dit un truc du genre “la grammaire est le début du processus de pensée”… c’est pas mal, hein ? Tant il est vrai (et souvent vérifié) qu’une pensée géniale, mal explicitée, tombe dans l’oubli le plus souvent, faute d’avoir été “choppée au vol” et bien comprise par les gens a qui elle était destinée !

Dans notre société burgerisée, on assiste à un nouveau mode de fonctionnement, qui serait une sorte de “faire sans l’effort d’apprendre”… Par exemple : causer sans savoir le faire, écrire bourré de fautes, mettre son grain de sel alors qu’on ne connait rien du domaine dont on parle, jouer de la zic sans jamais avoir appris (et souvent en étant vraiment pas doué !) LOL… plus un autre grave problème de notre société : tout doit être gratuit ! Les choses, les produits, les services, le travail, internet, les ordis et… terriblement pire… les Humains, parfois, n’ont plus de valeur !

Il est tellement plus profitable, plus gratifiant d’apprendre et de se sentir évoluer avec son appren-tissage (tisser ses connaissances, en quelque sorte !) et de savoir que tout à un prix… même si c’est GRATUIT (le prix est simplement caché derrière une arnaque ou un mensonge !).

L’instabilité économique et sociale de nos sociétés, avec son chômage galopant et endémique, ses parents qui baissent les bras face aux dangers d’un monde techno jamais analysés, jamais discutés en famille… en toute convivialité, en toute affection ! Cette instabilité rend les plus fragiles toujours plus fragiles… et c’est TRES grave !

Bon, je m’égare un peu… mais il y aurait tellement à dire… à se dire toutes et tous ENSEMBLE… sans perdre une seule miette de ce qui s’appelle IN-TEL-LI-GEN-CE… individuelle et collective !

François, tu pourrais mettre ma carte de voeux en ligne… c’est un “Appel au Peuple” :-))

La bise à tout le Monde :-*

, le 10.01.2009 à 17:02

@weiki: il me semble, au contraire que tout devient payant, que tout est privatisé; pour la santé, l’école, la justice, ça vient.

, le 10.01.2009 à 17:39

Mais c’est exactement ce que je dis concernant l’informatique. On veut du simple à utiliser tout de suite sans lire une seul ligne de notice. Sans même avoir pris le temps de comprendre le BAba de la structure de fichiers d’un ordinateur. Quand j’écoute les critiques de logiciels des personnes avec qui je me trouve, quand je lis les critiques sur les forums ou les commentaires, dans 80% des cas la réponse se trouvent dans les premières lignes de l’aide ou du ReadMe du soft. Je ne comprends pas qu’on remette en cause une personne qui ne sait pas bien écrire et qu’on accepte pas de se remettre en cause soit même lorsqu’on fait parti des 10% de personnes qui ont du mal avec un ordi alors que les 90% d’autres y arrivent

On me donne plus haut le lien de dico en ligne, quand je répondrai à des questions sur des forums, des commentaires de VersionTracker, ou par email, je donnerai le lien des notices technique Apple. Sous entendu “quand tu auras lu ça, tu reviendra poser des questions.”

Il est normal de souhaiter que l’interface homme machine s’améliore encore, mais aujourd’hui l’interface est comme elle est, et convient tant bien que mal à énormément de personne. Entendre répéter sans cesse que c’est mal fichu sans se remettre soi même en cause m’agace.

J’ai fait ce parallèle avec la langue parce que :

Quand tu fais une connerie sur ton ordi et vient pleurer sur un forum 9 personnes viennent t’aider et 1 se moquera.

Ecris une phrase avec des fautes …

Effectivement chacun ses lacunes, quand je fais des fautes je traite pas de crétins tous ceux qui écrivent correctement. Le premier réflexe d’un utilisateur de logiciel après une fausse manip est de maudire son concepteur, et par là même tous ceux qui l’utilisent correctement.

, le 10.01.2009 à 19:13

C’est gentil, merci à toi de penser à ma fête :)

Alors, tout d’abord, je ne parle pas d’un CDRom mais d’un cédérom terme officiel de l’Académie Française pour désigner les supports d’enregistrement optique à usage numérique, terme qui n’a pas de raison de ne pas englober toute forme de CD-Rom, CD-I, CD-R ou DVD :p

D’autre part, je peux même sauver 20go sur CD-Rom, il n’y a pas de problème. Qui a dit que je n’utilisais qu’un seul CD-Rom? Avec iTunes pour sauver ta musique, par exemple, il te dit :”J’ai besoin de 6 disques, veuillez insérer le premier” et hop, il te faut environ 10mn avec un graveur récent pour 4Go!

Enfin, 700Mb sur un CD-Rom est une norme mais pas une limite. En fait, cette norme permet d’avoir le meilleur compromis entre une fiabilité de la gravure des 1 et 0, ainsi qu’une fiabilité en lecture à des vitesses élevées. Rien n’interdit d’augmenter dramatiquement la densité d’écriture en réduisant les plages de 1 et 0… D’ailleurs, cela a été fait puisqu’il existe des CD-Rom avec graveurs spécifiques contenant 1,4 Go. Alors pourquoi pas 4Go :p

Alors satisfait de mes explications :p ^^

, le 10.01.2009 à 19:28

Le problème principal c’est que cela fait plus de 30 ans qu’il existe une littérature abondante sur comment doit être une interface utilisateur et que cela est méprisé par la plupart des outils de développement proposés aux développeurs (Interface Builder impose certaines normes qui vont dans le bon sens).

D’autre part, il existe des sciences du génie logiciel et de la qualité logicielle. Il existe aussi des techniques connues très performantes depuis les années 70 dans la gestion des systèmes d’exploitation, de la mémoire, du processeur…

Comment, dès lors, peux-t-on accepter si peu de qualité et de bon sens dans l’informatique d’aujourd’hui?

Par analogie foireuse, je dirai, pardonnerais-tu d’avoir une voiture qui, une fois sur deux parte en tête à queue alors même que l’on a la connaissance pour faire une voiture plus stable?

Au début de la voiture, c’est bien ce qui se passait pourtant jusqu’à ce que citroën révolutionne la voiture avec l’invention de la traction avant

Tout a montré (littérature et test) l’avantage de la traction avant pour la stabilité/contrôle/facilité de conduite et elle est, dès lors, adopté par toute l’industrie. Bien entendu, certaines voitures, souvent haut de gamme, dont les sportives, sont à propulsion mais pour des raisons spécifiques souhaitées par le conducteur ;)

, le 11.01.2009 à 09:29

Là encore, Kermorvan, j’avoue peiner… ou plus exactement ne pas comprendre grand chose à la suite d’Eugène Catalan. J’ai beau diviser des polygones réguliers en triangles… je ne trouve pas le lien entre une suite logique de polygones réguliers qui de toutes évidence (la mienne) commence par trois, puisque, a priori, un polygone à une ou deux faces n’existe pas (à l’exception bien sûr d’un cercle et d’un demi cercle, mais dont la division en triangles ne donne rien ou bien l’infini…).

Je suis donc dubitatif… ou plus exactement j’ai tout à apprendre, à commencer par l’écriture des mathématiques… Vaste, très vaste entreprise !

, le 11.01.2009 à 10:14

Le topo des références sur les nombres de catalan est là ; ce matin, ça fonctionne.

L’illustration de la triangulation des polygones est là . Ce qui n’est pas souvent précisé, c’est qu’un des côtés du polygone est pointé (le côté horizontal le plus bas, dans l’illustration de Sloane), ce qui fait que si l’on ôte ce côté pointé, et le triangle appuyé dessus, le polygone se casse en deux polygones pointés: c’est là la structure d’arbre binaire, qui est aussi celle du parenthésage, de l’emboîtement. Tout ça peut être montré aux enfants des écoles.

Note: L’outil informatique fondamental et intuitif, généralisation du parenthésage, lié aux langages algébriques de Chomsky et Schützenberger, qui ont mis fin à un certain merdier qui régnait dans les langages de programmation dans les années cinquante, c’est la pile.

(edit) Je vois que dans les dessins de Sloane manque une chose essentielle: l’initialisation de la récurrence par le vide. C’est une faute grave. C’est pourquoi la suite de catalan commence par 1 1 …

, le 12.01.2009 à 17:04

Merci ! je n’ai pas tout compris, mais j’ai apprécié la suite de Catalan en musique… c’est déjà ça ! ;-)

, le 12.01.2009 à 18:31

La meilleure représentation des arbres binaires:

– nous partons de x, arbre initial, et seul arbre dont les parties gauche et droite sont vides

– si nous avons construit les expressions m et m’, nous avons le droit de construire l’expression (m,m’)

Ainsi, nous construisons

La structure est binaire: excepté x, chaque expression a une partie gauche et une partie droite.

Ceci peut être pris comme le point de départ d’un cours d’algèbre. C’est la structure de base du premier langage de programmation proprement défini de l’ère informatique, le Lisp, 1958 (immédiatement suivi par Algol).

Le nombre d’expressions qui comportent n fois le caractère x, c’est le n-ième nombre de catalan.

, le 12.01.2009 à 19:14

Tu parles du langage incroyablement saturé de parenthèses? ;-)

, le 12.01.2009 à 19:49

Je parles du premier langage défini par une grammaire rigoureuse. Merci Mac Carthy, Chomsky, Schützenberger. Vous pouvez toujours les lire. Le Lisp (toujours utilisé, si je ne m’abuse) était interprété. Algol a suivi, compilé. Les parenthèses étaient toujours là; seulement elles s’appelaient (début, fin), (si, alors, sinon, finsi) , (pour, tantque, faire, finpour)…………

(additif préventif): C’est idiot de qualifier le Lisp de “langage d’intelligence artificielle”; si les gens qui font de “l’intelligence artificielle” (activité que je réprouve) l’utilisent, c’est uniquement du fait de sa rapidité à développer des arbres binaires, et aussi pour l’utilisation d’un ramasse-miettes dans la gestion de la mémoire par l’interprète.

(édit n°2) Il me semble que les premiers compilateurs Algol ont été écrits en France, à Grenoble ? C’est la gloire de ces gens d’avoir produit une informatique rigoureuse; ils n’ont pas été suivis par les firmes que nous connaissons, dont le seul but a été de faire du fric, tout en brevetant la moindre connerie.

, le 12.01.2009 à 20:52

Tenez, vous pouvez lire ceci, ce n’est pas toute la vérité, mais c’en est une bonne partie.

, le 12.01.2009 à 22:26

Bel épitaphe épistémologique…

Pour ce qui concerne “l’intelligence artificielle”, les tentatives de traducteurs automatiques sont la première barrière à franchir… on en est très loin… immensément loin car il ne s’agit pas seulement de traduire des mots et des “formules” grammaticales et lexicales, mais encore de donner un sens global à un texte et donc d’avoir des connaissances connexes qu’une machine n’est pas prête d’acquérir.

Exemple classique “Time flies like an arrow” qui signifie bien sûr “les mouches du temps aiment une flèche”… ou bien ?

On en revient à la différence entre langage humain et communication, entre le polysémique et l’univoque, etc.

, le 13.01.2009 à 09:08

@alec6

Voici où nous a menés l’entier 42; j’arrête là, mais nous pourrions continuer sans fin, partant des polygones triangulés ou des arbres binaires (c’est la même chose), puisque c’est de là qu’est parti Schützenberger lui-même (et aussi des textes de Touchard, français du dix-neuvième qui fut un peu méconnu dans son pays, comme il arrive souvent) pour fonder ce que l’on appelle la théorie des automates et la linguistique formelle. Il faudrait ajouter, ce que j’ai omis de mentionner, l’héritage incontournable d’Alan Turing, qui a donné, et ça nous renvoie au lien vers Bouveresse (voir plus haut dans ce fil), une version bien plus compréhensible des théorèmes de Gödel.